Introduction

DQN은 Neural network를 쌓음으로써 Q-learning 의 high dimension observation space을 input으로 받아 쓸 수 있게 되었지만, high dimension action space에서는 잘 작동하지 않았음.

굳이굳이 continuous action space에서도 DQN을 적용 시킬 수 있다.

continuous 한 action 이지만 이를 몇 가지의 discrete 한 action으로 discretize 하는 것이다.

그러나 action의 개수는 freedom의 정도에 따라 지수적으로 증가하기 때문에 단순히 행동이 3개로 discretize 한다고 한들 freedom이 7이라면 전체 action space의 dimension은 (= 2187) 이 되기 떄문에 Curse of dimensionality 에 빠져버릴 수 밖에 없다. (당장 로봇 팔 움직이게 하는 것만 해도 discretize 해서 쓰는게 불가능해보임)

또한, Vanilla Actor-Critic의 경우에는 neural function approximator를 사용하다보니 어려운 task에서 불안정하다는 문제점이 있었다.

따라서 DDPG 에서는 Actor-Critic과 DQN(replay buffer, target Q) 의 방식을 결합하여 안정적으로 function approximation을 학습하고자 만든 모델이다.

Background

Reinforcement Learning 의 목표는 Expected Return 을 maximize하는 policy를 학습하는 것이다.

이 Return은 policy 를 따르는 state와 action 의 distribution에 따라 계산된다.

•

Bellman Equation

는 policy 를 따라 state 에서 stochastic하게 선택될수 있는 action 들 중 하나이다. 그렇기 때문에 policy 가 stochastic하다면 에 대해 expectation을 취해야한다.

•

Bellman Equation (deterministic policy)

policy 가 deterministic하다면 에서 어떤 를 할지에 대한 uncertain이 사라지기 때문에, 이 명확하게 결정된다. 다시 말해, action이 단 1개로 고정된다.

deterministic policy로 바꿨을 때 수식을 보면 Expectation이 environment 에만 의존하는 것을 볼 수 있다. 다시 말해 특정 state에서 특정 action을 했을 때, environment이 어떻게 반응하는지는 policy에 전혀 영향이 없다는 것을 말한다.

따라서, data를 수집할 때에는 다른 policy (예 : ) 를 쓰더라도, 수집한 data를 사용하여 target으로 하는 policy 를 학습할 수 있다. (= off-policy)

•

Q-learning

DQN에서는 epsilon greedy하게 뽑았지만 여기에서는 policy 가 deterministic하기 때문에, greedy policy인 를 사용한다.

•

Loss

위에서 말했듯 data를 수집할 때에는 policy 를 가지고 하며,

Loss는 를 사용하여 Q-function를 approximation하고 있다. 를 minimize하는 방향으로 진행하며, DQN 같이 Mean Squared Error 를 사용한다.

•

target Q

는 에서 선택된 action 에 따른 reward과 미래의 Q-값을 더한 것이다.

도 에 의존적이지만, 일반적으로 무시된다.

→ 는 Loss 계산할때 target값으로 사용된다. 학습 과정에서 가 와 최대한 비슷해지도록 를 업데이트하는 것이므로, 가 특정 time step 에서의 에 직접적으로 영향을 받지 않게 고정된 값으로 취급된다.

Algorithms

앞서 Q-learning의 문제점 (continuous domain에서는 매 time step매다 greedy 한 policy를 찾기 위해 에 대한 optimize를 수행하는데 neural network 와 함께 쓰면 계산 비용이 너무 높다)

때문에 continuous domain에서 쓸 수 없으므로, Deterministic Policy Gradeint 을 사용한다.

DPG (Deterministic Policy Gradient)

•

Parameterized actor function

state를 특정 action으로 deterministic하게 mapping하는 policy를 의미한다.

Chain Rule 에 의해 update 되며 distribution으로 부터 expected Return 에 대한 actor parameter 로 진행된다.

•

Critic function

Q-learning과 같이 bellman equation을 통해 학습된다.

•

Policy Gradient

밑의 수식 2개 모두 Chain Rule를 적용하여 gradient 를 계산하는 부분이다.

먼저, 위의 수식은 Q-function의 action 에 대한 gradient를 의미하며,

위 수식은 policy 의 parameter 에 대한 gradient를 의미한다.

NFQCA (Neural Fitted Q Iteration with Continuous Actions)

Q-learning와 마찬가지로 non-linear approximation 을 넣으면 수렴하지 않을 수 있고, 반대로 continuous domain에서는 linear approximation 만으로는 학습이 어렵다.

DPG 와 동일한 update rule를 쓰면서도 non-linear approximation을 넣는 대신에 batch learning을 추가하여 안정성을 보장하였다.

다시 말해, batch learning을 하지 않는 NFQCA는 DPG와 동일하다.

그래서 DDPG는 NFQCA 알고리즘을 기반으로 하여 DPG의 일부 수정을 통해 continuous domain에서도 학습이 가능하도록 만들었다.

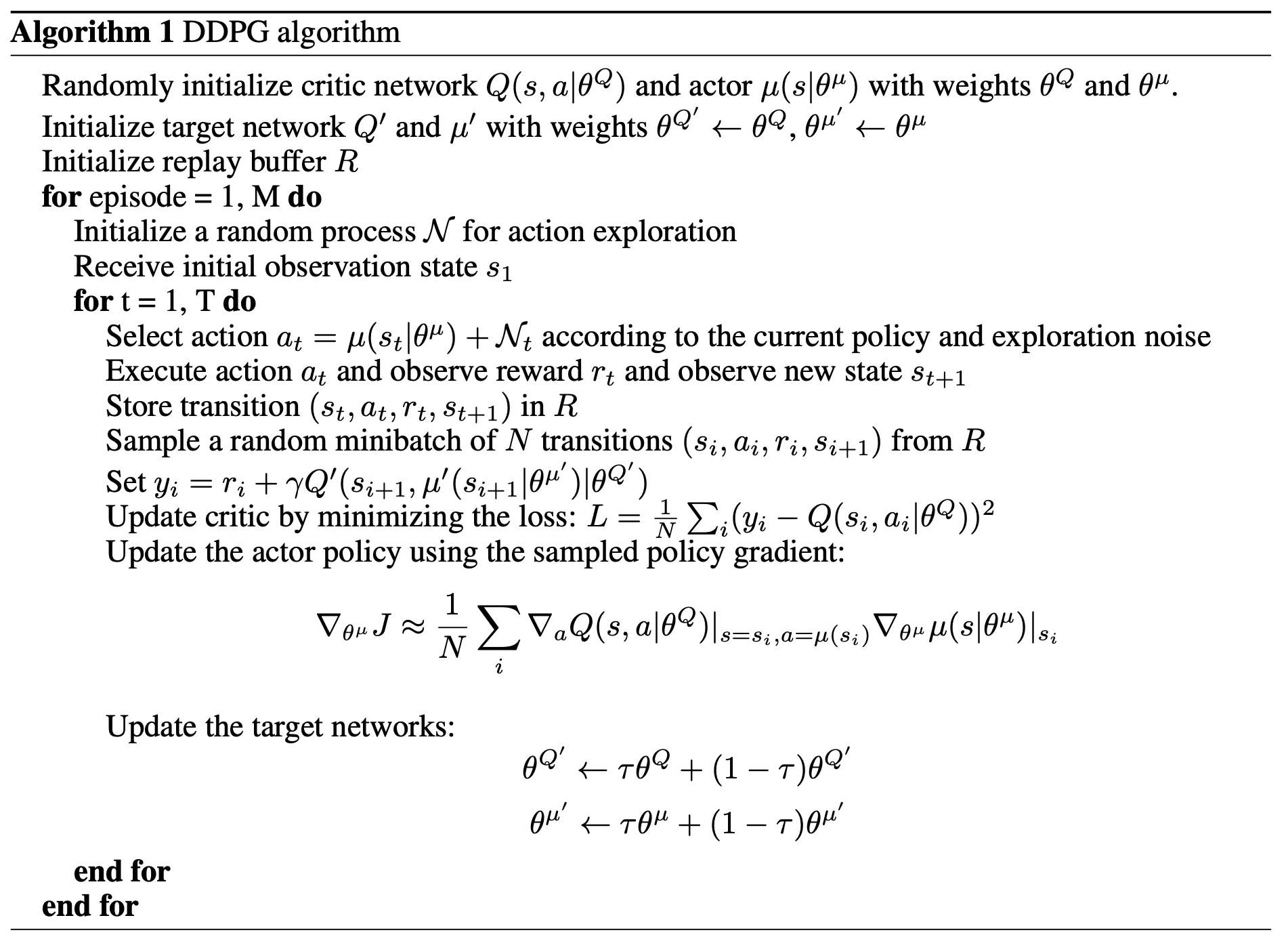

DDPG (Deep Deterministic Policy Gradient)

•

mini-batch learning

앞에서 이야기 했던 것처럼 신경망을 강화학습에 사용할 때, 대부분의 알고리즘은 sample 이 독립적이고, 동일하게 분포되어 있다는 가정이 필수적이다.

그런데 on-policy 방법 처럼 sample를 순차적으로 exploration하고, 생성해내면 state와 action간의correlation 문제가 발생하기 때문에 학습이 불안정해질 수 있다.

→ Replay buffer를 사용하여 mini-batch 학습을 진행한다.

•

Soft target update

가 update되면서, 동일한 network가 target value 계산할 때에도 사용되기 때문에 학습 중에 network가 빨리 변하면서 수렴하지 않을 수 있다.

마찬가지로 DDPG에서도 target network를 사용하긴 하지만 actor-critic 구조에 맞게 변형하였다. network의 weight를 직접 복사해서 쓰는 대신 천천히 변화시키는 방법을 사용한다.

와 와 같이 복사본을 만들고, 이 target을 계산하는데 사용한다.

다음과 같이 를 1보다 작은 수로 결정하여 학습된 network의 weight를 천천히 따라가도록 만들었다.

위의 2가지 방법을 추가하여 Q-learning이 가지고 있던 unstability 문제를 supervised learning 문제로 바꾸어 안정적으로 학습할 수 있도록 만들어주었다. 추가적으로 target policy 와 target Q-function 모두 쓰는 것이 중요하다.

이를 통해 Critic이 발산하지 않고 안정적으로 수렴할 수 있었다고 한다.

물론 soft target update의 경우 천천히 따라가는 방식이다보니 학습 속도는 느리지만, soft target update를 썼을 때와 안썼을 때의 안정성 차이가 크게 났다고 한다.

•

Problems with low-dimensional feature vectors

feature vector의 observation은 서로 다른 물리적 단위(예: 위치, 속도)를 가질 수 있으며, 환경에 따라 범위가 다를 수 있다.

이러한 차이로 인해서 network가 효과적으로 학습이 불가능할 수 있으며, 서로 다른 범위를 가진 state value 들을 일반화할 수 있는 hyperparameter를 찾는 것이 어려워질 수 있다.

이러한 문제를 해결하기 위해 batch normalization 를 사용하였다.

즉, mini-batch 내의 차원을 normalization해서 평균이 0이고, 분산이 1이 되도록 만드는 것이다.

low-dimension state space에서 batch normalization를 state input의 모든 layer와 Q-network의 모든 layer에 적용하였다.

따라서, 다양한 physical unit & range 를 가진 task에서도 효과적으로 학습할 수 있었다.

•

Exploration in continuous action space

위에서 봤듯 DDPG는 off-policy 알고리즘으로 data를 수집할 때 사용되는 policy () 와 training 에서 사용되는 policy () 가 다르다.

deterministic policy는 주어진 state에서 항상 동일한 action 만 하기 때문에 exploration을 좀 더 하도록 만들어주기 위해 noise를 추가하는 것으로 보인다.