Introduction

•

2가지 주요 challenge

1.

model-free RL 알고리즘은 sample complexity 측면에서 비용이 많이 들어간다. 간단한 작업에서도 수백만 단계의 데이터 수집이 필요할 수 있고, large, continuous space로 갈 수록 훨씬 더 많은 데이터를 필요로 한다.

2.

hyperparameter과 관련해서 잘 설정해야 좋은 결과를 얻을 수 있다.

•

on-policy의 문제점

Deep-RL에서 sample complexity가 떨어지는 원인 중 하나는 on-policy이다.

“off-policy” 알고리즘은 이전 experience를 다시 사용하지만 (Replay memory) ,

”on-policy” TRPO, PPO, A3C 와 같은 알고리즘은 각 gradient step에 대해 새로운 sample을 수집하는 방식으로 진행한다는 점에서 sample complexity 문제가 있다.

그러나 off-policy(DQN) 경우에는 continous space에서는 사용하기 어렵다는 문제점이 있다.

따라서 continous space에서 사용할 수 있는 off-policy 알고리즘인 DDPG는 주어진 상태에서 행동을 결정하기 위한 하나의 Deterministic policy를 학습한다.

이 알고리즘은 off-policy이기 때문에 sample complexity가 높지만, 매우 민감한 하이퍼파라미터와 불안정성 때문에 쉽게 사용하기 어렵다는 문제점이 있다.

•

maximum entropy

SAC는 Soft Q-learning 기반의 Maximum Entropy 방법을 활용한 RL 알고리즘이다.

정보 이론에서 entropy가 높다는 것은 정보가 혼탁하다는 것이다.

그러니까 distribution으로 보면 확률값이 거의 동일한 uniform distribution과 동일한 상태인데 exploration을 하면서 gaussian distribution의 형태로 가는게 일반적이다.

Maximum Entropy RL의 목적은 expected return 과 policy의 expected entropy를 maximize하는 것이다. maximum entropy distribution은 policy를 high reward region으로 가도록 만든다는 점에서 상당한 장점이 있다.

Soft Q-learning : Policy Iteration + Maximum Entropy

preliminary

•

Standard RL

일반적인 RL에서는 reward의 expected sum를 maximize 하는 게 목적이었다.

•

Maximum entropy objective

entropy 항은 policy가 얼마나 random적인지를 표현한다. (exploration 을 조절)

가 커질수록 exploration를 더 많이하고, 반대로 → 0으로 갈 수록 expected reward를 maximize하는 일반 강화학습 알고리즘과 같아진다.

maximum entropy distribution은 policy를 high reward region으로 다로고 만든다는 점에서 좋다.

•

Maximum entropy 의 장점

1.

유망하지 않은 경로를 포기하면서 더 넓게 탐색하도록 장려된다.

2.

policy는 여러가지의 sub-optimal한 action을 포착할 수 있다.

3.

entropy based 학습은 exploration에서 기존보다 크게 개선되어 학습속도가 빠르다.

SAC의 특징

1.

infinite horizon 문제를 해결하기 위해 discount factor 를 사용하여 expected reward와 entropy의 합이 유한하도록 만듦

2.

앞에서 말했든 SAC는 (soft) policy iteration을 한다. 현재 policy의 Q-function을 평가하고, off-policy gradient update 방식으로 policy를 update한다. (이는 policy iteration으로 시작해서 maximum entropy varient를 적용해서 최종적으로 SAC로 유도할 수 있음)

From Soft policy iteration to Soft Actor-Critic

Soft policy evaluate

policy 의 value를 계산할 때에는 maximum entropy objective를 적용하겠다.

고정된 policy 에 대해서 soft Q value는 Bellman backup에 의해 반복적으로 적용되어 계산된다.

우리가 알고 있던 state value function에서 확률 분포 의 entropy 만 추가된 형태이다.

entropy항에 log항을 붙여주어 높은 확률이었던 것에 penalty를 더욱 크게크게 부여하는 식이다.

Soft policy improvement

policy를 다루기 쉽게 하기 위해서 특정 policy set 으로 제한하겠다.

그 이유는 가 에 속해야 한다는 제약하에 개선된 policy를 project 하고 싶은 것.

예를 들어 를 로 restrict 하는 과정에서 Gaussian distribution으로 parameterize할 수도 있다.

SAC에서는 편의성(?) 을 위해 Projection을 KL divergence 를 사용하여 정의하였다.

수식을 살펴보면, Q 에다가 exp를 달아주었기 때문에 action value function이 클 수록, 해당 action 이 좋다는 것이 더욱 부각이 되니까

→ “이전 policy에서 Q가 높았던 action은 에서 훨씬 높은 확률로 뽑겠다” 라고 이해할 수 있다.

그리고 는 확률 분포로 만들어 주기 위한 normalize term이다.

그래서 위와 같이 Projection해서 얻게 된 의 value function은 보다 크거나 같은게 증명할 수 있다.

Problems with soft policy iteration

여기까지 soft policy iteration에 관한 내용이었다.

정리하자면, 제한된 policy set 내에서 optimal maximum entropy policy 로 수렴할 수 있음이 수식적으로 증명했다.

그러나 optimal한 해를 얻는건 tabular case 일 때만. continuous domain 에서는 수렴할 때까지 하는건 너무 비용이 많이 든다.

continuous domain에서도 근사시키는 practical한 알고리즘이 SAC이다.

Soft Actor-Critic

Train soft value function

Soft policy iteration하는 거 대신 Q-function과 policy를 function approximation해서 쓰겠다.

한가지 특징은 원칙적으로는 state value에 대해 별도의 function approximation을 달아주지 않아도 되지만, soft value에 대한 function approximation을 달아주는게 학습에 안정화된다.

위의 수식은 실제 가치 와 기대 가치 의 squared residual error를 minimize하도록 soft value를 학습한다.

기대 가치 부분은 위에서 봤던 soft policy iteration 와 같다.

Train soft Q-function

soft Q-function은 TD-learning을 통해 update된다.

이때 Target Q에 위와 같은 trick을 사용하여 Q를 Value function으로 바꿔주고, 미분을 때린다.

Stochastic Gradient Descent를 사용히여 optimize할 수 있다.

Train soft policy improvement

위에서 봤던 soft policy improvement 수식이다.

KL divergence를 minimize하여 학습하는데, 일반적인 policy gradient였다면 likelihood ratio (TRPO, PPO) 를 사용해서 backpropagate 하겠지만, SAC의 경우에는 target Q가 로 정의되어있고, objective function은 로 정의 되어있기 때문에 미분하면 0되어 사라진다.

도 신경망이기 때문에 사라지면 안되기 때문에 target을 으로 reparameterize하는 trick을 사용한다.

다시 말해 원래 로 정의 되었던 수식으로 에 대해 재정의한다.

미분을 하기 전에 KL divergence의 수식 정의는 (아시겠지만) 다음과 같은데, log 성질에 의해 풀어쓴 soft policy improvement 수식이 밑의 수식과 같다.

(위의 수식을 미분한 결과)

(나처럼 수식에 약한 사람이 전개하다보면) " + ” 를 기준으로 오른쪽 항은 문제없는 거 같은데, 왼쪽 log항은 왜 튀어나오는지 의문일 수 있다.

그 이유는 chain rule에서 중간 값인 가 에 의존적인 상황이기 때문에 편미분이 아닌 total derivation을 계산해줘야 한다. 그런 이유 때문에 튀어나오는 것이다.

Additional Features of SAC

1.

policy improvement 단계에서 positive bias 문제를 해결하기 위해 2개의 Q-function을 사용한다.

2개의 Q-function을 독립적으로 학습하여, 각 Q-function은 별도의 parameter 를 갖는다. 그리고 train도 독립적으로 optimize한다. →

2.

value gradient (Train soft value function 부분) 와 policy gradient (Train soft policy improvement 부분) 할 때에는 2개의 Q-function 중에서 작은 값을 사용하겠다.

Q-function의 overestimation 문제를 해결하기 위함도 있고, clipping 효과로 안정적인 학습을 하기 위함이다.

3.

environment으로 부터 경험을 쌓고, replay buffer에서 batch만큼 뽑아서 function approximation으로 update하는 과정을 번갈아가면서 한다.

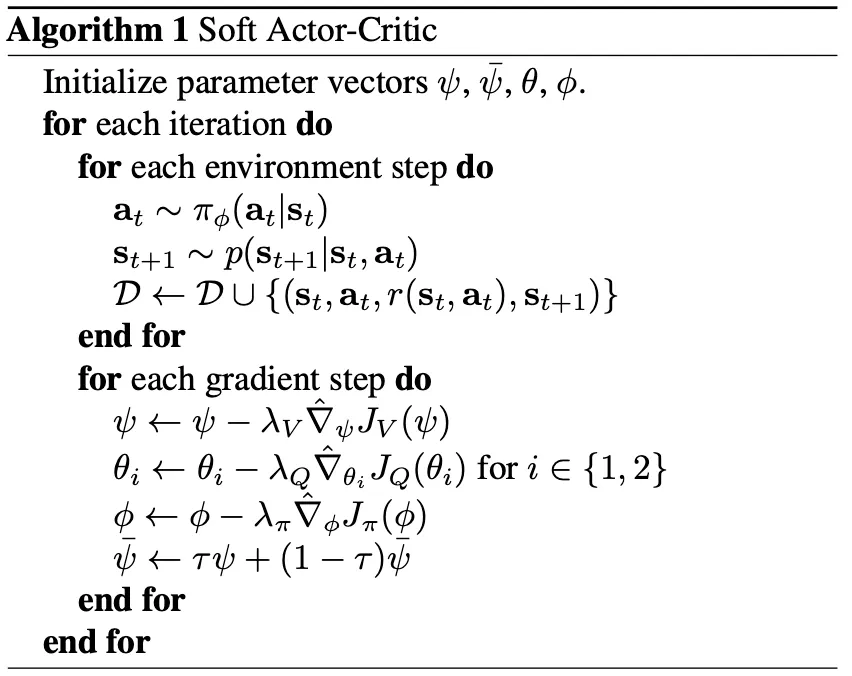

SAC pseudo code

“맨 마지막 줄은 기존의 target value에 대해 조금씩 value를 update하겠다” 라는 의미.

(DDPG, TD3 와 비슷한 soft value update)